哈哈,发现word也可以直接发送到wordpress,今天试试,以后便开启学习之旅吧!---闻新

下附内容仅用于学习,思考,遵循相应协议!

What is Federated Learning?什么是联邦学习

原文:

https://odsc.medium.com/what-is-federated-learning-99c7fc9bc4f5

联邦学习(Federated Learning,FL)是由Google AI在2017年的一篇博客Federated Learning: Collaborative Machine Learning without Centralized Training Data中首次介绍的,同时还有一篇现在具有开创性的研究论文,该论文通过深入讨论名为Federated Optimization: Distributed Machine Learning for On-Device Intelligence (2016)的新方法,为联邦学习奠定了基础。

Federated Learning: Collaborative Machine Learning without Centralized Training Data

(大致浏览了该文章)该文章提出,相较于基于数据中心/云端进行中心化计算的"标准化机器学习",针对models trained from user interaction with mobile devices,引入了联邦学习的概念。

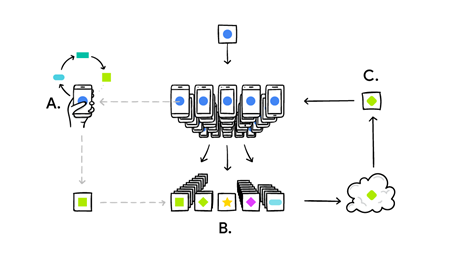

联邦学习框架下,

-

各移动设备下载一个相同的共享预测模型,利用各自数据进行计算,并提出总结出相应的模型更新信息。

-

利用加密通信仅向云端/数据中心传输模型更新信息,并迅速同多个用户上传数据以平均处理优化模型。

-

循环往复这个过程。

在这个过程中,个人设备的数据不会上传,从隐私保护方面有一定作用,此外,各用户模型更新信息在未提交前便可直接用户改进其自身的功能,并带有一定的个性化特色。

新的方案,同时带来新的挑战,文中提出 高度迭代的算法需要保持同训练数据集的低延迟、高通量(high-throughput)连接。而在联邦学习框架下:

-

据以极不平衡的方式分布在树百万个设备中。

-

各设备均为间歇性运行训练学习,延迟更高且低通量连接。

-

现代移动设备的高性能处理器也许运算效果更佳。

-

需要考虑异质设备,适应设备的模型算法微缩化,以及不干扰正常设备运行性能(也许仅在闲置联网时,运行算法)。

-

整体系统需要保证安全性、高效性、可扩展性及鲁棒性。

…综合考虑如上各方面的问题,才能具体展开联邦算法的应用。

联邦学习的优点之一在于用户数据的不上传以保护隐私,在此基础上,文中还提出了一种安全的聚合协议,其在于对于用户提交的模型更新信息,协议要求服务器仅能在多用户平均处理后,才可读取更新,而不能单独检查单一用户的模型更新信息,以此来规避通过用户的模型更新信息的处理以反向得到用户数据的可能。

(经了解,公司若想了解用户的数据,有可能将用户数据隐藏在提交的模型数据中,(深度学习,神经网络中的参数大小可不小)明确具体的协议,究竟能否约束公司不查看用户的数据呢?这是个问题!本节最下面的动画似乎可以进行一定的解释!)

文中提到了两个可能的实用场景,一者是用户输入时的联想建议(Gboard query suggestions),如下:

二者则是根据用户在设备上实际键入的内容(也许具有个人风格)改进语言模型、人们查看、分享或删除的照片类型来进行photo rankings。

文末指出:

联邦学习需要我们采用新工具和一种新的思维方式,在无需直接访问或标记原始数据,并以通信成本作为限制因素条件下,进行模型开发,训练及评估。

What is Federated Learning?该文在上边这篇的基础上,进一步介绍了联邦学习的优势,挑战以及最近的进展。

详见翻译页面:

https://datac.blog.csdn.net/article/details/109295287

其对于联邦学习的特性及优缺点描述很贴切。

相关学习资料:

一个有趣的动画,来解释什么是联邦学习,其将整个流程,及可能的答案融入了动画!

推荐https://wxcui.top/wordpress/file/Federated%20Learning_SingleFile.html

注:该动画html文件是利用Singlefile插件生成的拷贝件,遵循Creative Commons Attribution-Noncommercial-NoDerivative Works 3.0 license.

10/20/2022 9:26:09 PM